Large Language Models (LLMs) in Confluence

Die Zukunft der Wissensintegration

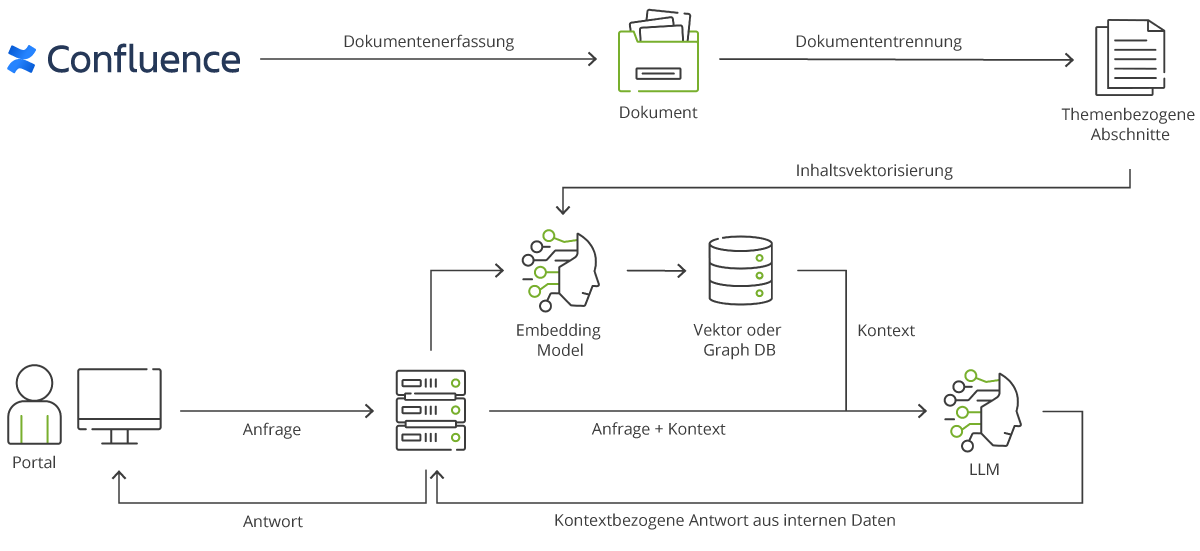

Unsere innovative Lösung kombiniert die Vorteile von LLMs (z. B. OpenAIs GPT oder Metas Llama-2) mit der umfassenden Wissensbasis von Confluence, um Ihnen ein einzigartiges Werkzeug für die Beantwortung von Fragen und die Optimierung von Wissensaufbereitung zu bieten.

Das Konzept, basierend auf der Retrieval Augmented Generation, vereinfacht die Art und Weise, wie Sie auf firmeninterne Inhalte zugreifen. Die Integration von LLMs in Confluence ermöglicht es Ihnen, mühelos und intuitiv auf Ihr Unternehmenswissen zuzugreifen.

Wie funktioniert es?

Datenextraktion & Bewertung

LLMs extrahieren Informationen aus Confluence und bewerten diese nach Relevanz.

Datenbankaufbau

Die bewerteten Informationen werden in einer speziellen Datenbank gespeichert, um einen effizienten Abruf zu ermöglichen.

Nutzerinteraktion

Nutzer stellen Fragen über die Benutzerschnittstelle und LLMs analysieren den Kontext, wählen relevante Informationen aus der Datenbank aus und bereiten sie für die Antwort vor.

Antwortgenerierung

Das Sprachmodell generiert präzise Antworten unter Berücksichtigung des bereitgestellten Kontextes.

User Interface

Die Verbindung zum User Interface erfolgt durch eine dynamische Implementierung in HTML, CSS und JavaScript.

Einsatzbereiche

Kundensupport

Sofortige Antworten auf Kundenanfragen durch intelligente Nutzung Ihrer Confluence-Wissensdatenbank.

Mitarbeitersupport

Unterstützen Sie interne Teams, indem Sie schnell auf technische und fachliche Fragen reagieren.

Wissenstransfer & Schulungen

Begleiten Sie Mitarbeiter durch Wissenstransfer und Schulungen in Echtzeit.

Analyse von Firmendaten

Extrahieren Sie wertvolle Erkenntnisse aus Ihren Confluence-Inhalten, um datengesteuerte Entscheidungen zu unterstützen.

Flexibel und anpassbar

Standalone oder Integration

Nutzen Sie LLMs in Confluence entweder als eigenständigen Webchat oder integrieren Sie ihn nahtlos in bestehende Plattformen und Portale.

Anpassung an Kundenbedürfnisse

Ob als Standalone Webchat oder als Pop-up Chatbutton, passen Sie die Integration flexibel an die Bedürfnisse Ihrer Kunden an.

Kurzzeitgedächtnis

Unser System merkt sich vorherige Interaktionen, um auf Folgefragen gezielter und effizienter reagieren zu können.

Entdecken Sie die Zukunft der Wissensintegration mit LLMs in Confluence!

Wir sind begeistert, Ihnen eine Lösung zu bieten, die die Effizienz steigert und die Art und Weise, wie Sie auf Unternehmenswissen zugreifen, grundlegend verändert